RoBERTa (Robustly Optimized BERT Pretraining Approach), makinelerin doğal dil işleme yeteneklerini geliştirmek için geliştirilmiş olan birinci sınıf bir dil modelidir. RoBERTa, doğal dil işleme alanında en yaygın olarak kullanılan dil modellerinden biri olan BERT'in (Transformerlardan İki Yönlü Kodlayıcı Temsilleri) gelişmiş bir versiyonudur. RoBERTa'nın temel hedefi, BERT'in bazı sınırlamalarını aşmak ve çeşitli NLP görevlerinde daha kesin ve güvenilir sonuçlar sunmaktır. Bu gelişmiş dil modeli, dinamik maskeleme gibi gelişmiş eğitim tekniklerinden yararlanarak ön eğitim sürecini optimize etmekte ve sağlamlığını artırmaktadır. RoBERTa, büyük bir metin veri kümesi üzerinde eğitilmiş olup, insan dilinin inceliklerini anlama yeteneğine ve doğru tahminler sunabilme yeteneğine sahiptir. İyileştirilmiş eğitim teknikleriyle RoBERTa, duygu analizi, metin sınıflandırması ve soru-cevap sistemleri gibi çeşitli NLP görevleri için vazgeçilmez bir araç haline gelmiştir. Bu makalede, RoBERTa'nın çeşitli özelliklerini ve NLP uygulamalarının performansını nasıl artırdığını inceleyeceğiz.

RoBERTa, "Robustly Optimized BERT Pretraining Approach"ın kısaltması olan BERT'in gelişmiş bir sürümüdür. Doğal dil işleme görevlerinde daha doğru sonuçlar veren geliştirilmiş eğitim tekniklerine sahiptir.

RoBERTa, doğal dil işleme görevlerinde BERT'ten daha kesin sonuçlar veren gelişmiş eğitim tekniklerine sahiptir. Ayrıca daha fazla miktarda eğitim verisini ve daha uzun süreli eğitim sürelerini kullanır.

RoBERTa kullanmanın faydaları arasında doğal dil işleme görevlerinde artan doğruluk, dilin inceliklerini daha iyi anlama ve daha güvenilir sonuçlar yer alır.

Evet, RoBERTa, duygu analizi, metin sınıflandırması ve soru-cevap gibi birçok doğal dil işleme görevi için uygundur.

RoBERTa, GLUE sınavı görevleri ve SQuAD 2.0 dahil olmak üzere çeşitli doğal dil işleme görevlerinde diğer önde gelen modelleri geride bıraktığı gösterilmiştir.

RoBERTa, eğitim için genel olarak kamuya açık web verileri ve alan özgü verilerin bir kombinasyonunu kullanır. Aynı zamanda BERT'e göre daha uzun eğitim süreleri ve daha fazla veri kullanır.

Evet, RoBERTa, görev özel veriler ve ayarlama teknikleri kullanılarak özel doğal dil işleme görevleri için ayarlanabilir.

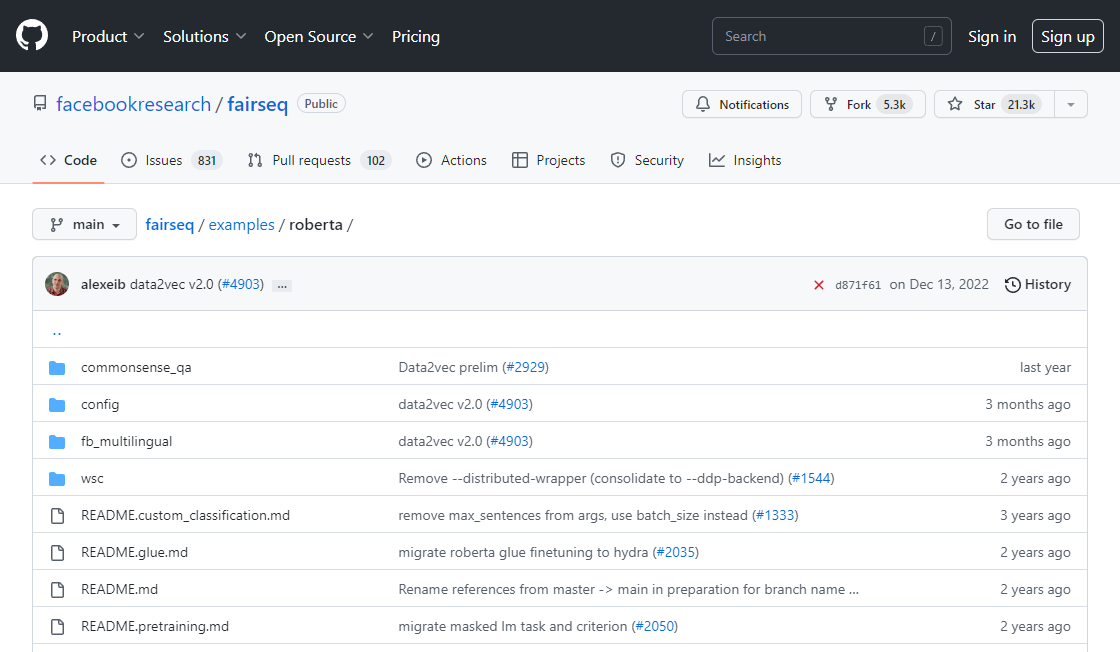

Evet, RoBERTa açık kaynak bir projedir ve ücretsiz olarak indirilebilir.

RoBERTa'yı doğal dil işleme projelerinizde kullanmak için modeli indirip belirli göreviniz için finetune yapmanız gerekmektedir.

RoBERTa'nın doğal dil işleme teknolojisinde ilerlemeye devam etmesi ve sağlık, finans ve müşteri hizmetleri gibi daha fazla uygulama ve sektörde kullanılması beklenmektedir.

| Rekabetçi | RoBERTa'dan Farkı |

|---|---|

| GPT-3 | RoBERTa'ya kıyasla farklı bir mimari ve eğitim yöntemi kullanır (denetimsiz öğrenme) RoBERTa ise denetimli öğrenme yaklaşımı kullanır |

| XLNet | Permütasyon tabanlı bir eğitim yöntemi ve oto-regresif dil modelleme hedefi kullanırken, RoBERTa yalnızca maskeleyerek dil modellemesi hedefi kullanır |

| ALBERT | Model doğruluk seviyesini tehlikeye atmadan eğitim verimliliğini artırmak için parametre azaltma teknikleri uygularken, RoBERTa pre-training hedefleri ve tekniklerinin optimizasyonuna odaklanır |

| ELECTRA | Gerçek ve sahte giriş simgeleri arasında ayrım yapmak için bir ayrımcı model kullanırken, RoBERTa maskeleme tabanlı bir dil modellemesi hedefi kullanır |

| T5 | Doğal dil de dahil olmak üzere çeşitli girdilerden metin üretmeye odaklanırken, RoBERTa başlıca temsil öğrenimi ve aşağı akış görevlerinde ince ayar için kullanılır |

RoBERTa (Robustly Optimized BERT Pretraining Approach), BERT'in geliştirilmiş bir versiyonu olarak ortaya çıkmıştır ve doğal dil işleme yeteneklerini geliştirmek için iyileştirilmiş eğitim tekniklerinden faydalanır. RoBERTa hakkında bilmeniz gereken en önemli şeyler şunlardır.

1. RoBERTa, BERT'in geliştirilmiş bir versiyonudur.

RoBERTa, Bidirectional Encoder Representations from Transformers (Dönüştürücülerle İki Yönlü Kodlayıcı Temsilleri) anlamına gelen BERT'in geliştirilmiş ve ileri düzeyde bir versiyonudur. BERT, metin sınıflandırma, isim varlık tanıma ve soru-cevap sistemleri gibi doğal dil işleme görevleri için kullanılan sinir ağı tabanlı bir tekniktir. RoBERTa benzer bir teknolojiyi kullanır, ancak daha ileri eğitim tekniklerine sahiptir.

2. RoBERTa, daha büyük bir eğitim corpusu kullanır.

BERT ve RoBERTa arasındaki temel farklardan biri, eğitim corpusunun boyutudur. RoBERTa, daha büyük ve çeşitli bir eğitim corpusunu kullanarak sinir ağını eğitir. Bu, dil kalıplarını ve nüansları daha iyi anlamasını sağlar. Daha büyük corpus Wikipedia, web sayfaları, kitaplar ve diğer kaynaklardan gelen verileri içerir.

3. RoBERTa, dinamik masking kullanır.

BERT'te bir cümledeki belirteçler rastgele maskelemeye tabi tutulur ve model maskeleme yapılan belirteçleri tahmin etmeye çalışır. Buna karşılık, RoBERTa, her belirtecin maskeleme olasılığına bağlı olarak maskeleme yapar. Bu yaklaşım, modelin daha çeşitli bir kümedeki maskeleme yapılan belirteçler üzerinde eğitilmesini sağlar ve daha iyi performans elde edilmesini sağlar.

4. RoBERTa, birden fazla NLP görevinde BERT'i geride bırakır.

Birçok deney, RoBERTa'nın çeşitli doğal dil işleme görevlerinde BERT'i geride bıraktığını göstermektedir. Örneğin, NLP görevlerinde modellerin performansını ölçen GLUE benchmarkunda, RoBERTa 90.4 puanla yeni bir state-of-the-art puanını kaydederek BERT'in önceki yüksek puanı olan 88.5'i geçmiştir.

Sonuç olarak, RoBERTa, doğal dil işleme yeteneklerini geliştirmek için iyileştirilmiş eğitim tekniklerinden faydalanan BERT'in önemli bir gelişmiş versiyonudur. Daha büyük bir eğitim corpusu ve dinamik masking kullanarak, RoBERTa birden fazla NLP görevinde BERT'i geride bırakır ve doğal dil işleme alanında değerli bir araç haline gelir.

Topluluk için bir inceleme bırakın