DistilBERT, son yıllarda ivme kazanan bir yapay dil işleme (NLP) yöntemidir. DistilBERT, Google tarafından 2018 yılında geliştirilen popüler bir NLP modeli olan BERT'in sadeleştirilmiş bir sürümüdür. DistilBERT, orijinal BERT'e göre daha küçük, daha hızlı, daha ucuz ve daha hafiftir ve doğal dilin anlaşılması için güçlü bir yöntem sağlar. Soru cevaplama, duygu analizi ve doğal dil çıkarımı gibi çeşitli görevlerde öncüsünden daha yüksek performans elde ettiği gösterilmiştir. BERT'in aksine, DistilBERT küçük veri setlerinde eğitilebilir ve daha az parametre ve kaynak gerektirir. Bu, hız ve verimliliğin önemli olduğu uygulamalar için idealdir. Ayrıca, DistilBERT, verideki ince dilbilimsel desenleri yakalayabilmesi nedeniyle transfer öğrenme senaryolarında güçlü bir özellik çıkarıcısı olarak kullanılabilir. Impresyon sağlayan performansıyla, DistilBERT birçok NLP görevi için tercih edilen seçenek haline gelmektedir.

DistilBERT, BERT'in daha küçük, daha hızlı, daha ucuz ve hafifletilmiş bir versiyonudur.

DistilBERT, BERT'ten daha küçük, daha hızlı, daha ucuz ve daha hafiftir.

DistilBERT, BERT'ten daha küçük, daha hızlı, daha ucuz ve daha hafiftir.

DistilBERT, bilgi distilasyonu ve model sıkıştırma gibi teknikleri kullanarak, BERT'ten bilgiyi distile ederek daha küçük bir boyuta ulaşır.

DistilBERT genellikle göreve bağlı olarak BERT'ten 2-3 kat daha hızlıdır.

Evet, DistilBERT genellikle BERT'ten daha ucuzdur, çünkü çalıştırmak için daha az kaynak gerektirir.

Evet, DistilBERT genellikle BERT'ten daha hafiftir, çünkü daha az parametreye sahiptir.

Evet, DistilBERT BERT ile aynı görevler için kullanılabilir, ancak aynı performansı göstermeyebilir.

Görevin tipine bağlıdır. Bazı durumlarda, DistilBERT BERT'ten daha iyi performans sağlayabilir, ancak diğer durumlarda BERT daha uygun olabilir.

Evet, DistilBERT, daha az kaynak gerektirdiği ve daha hızlı olduğu için BERT'ten daha kolay kullanılır.

| Rakip | DistilBERT'ten Farkı |

|---|---|

| BERT | Daha büyük, daha yavaş, daha pahalı ve daha ağır |

| RoBERTa | Daha küçük, daha hızlı, daha ucuz ve daha hafif |

| ALBERT | Daha küçük, daha hızlı, daha ucuz ve daha hafif |

| XLNet | Daha küçük, daha hızlı, daha ucuz ve daha hafif |

| XLM | Daha küçük, daha hızlı, daha ucuz ve daha hafif |

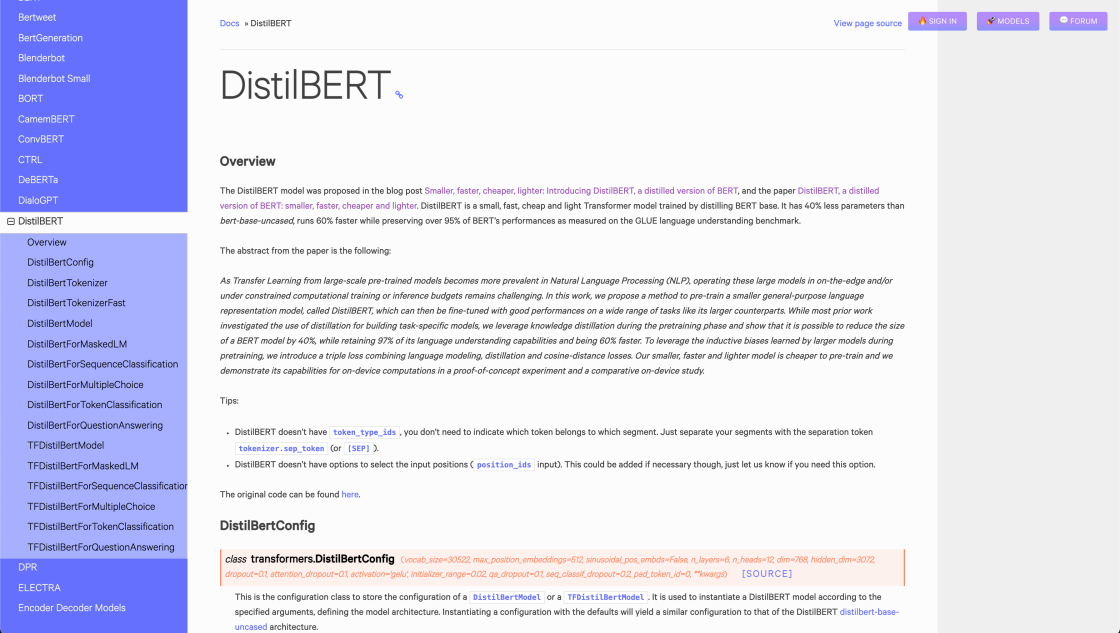

DistilBERT, popüler BERT'in (Bidirectional Encoder Representations from Transformers) sıkıştırılmış bir versiyonudur. Orijinal BERT'ten daha küçük, daha hızlı, daha ucuz ve daha hafif bir model sunar. DistilBERT, orijinal BERT modelinde daha az parametreye sahiptir, bu nedenle eğitimi daha kolaydır ve daha hızlı çalışır. Ayrıca, daha az bellek gerektirir, bu da sınırlı kaynaklara sahip uygulamalar için daha maliyet efektif ve idealdir. Ayrıca, DistilBERT, soru cevaplama, doğal dil çıkarımı, duygu analizi ve metin sınıflandırma gibi çeşitli görevler için ince ayar yapılabilir.

DistilBERT modeli, BERT ile aynı mimariye dayanmaktadır ve aynı hiperparametreleri kullanır. Bununla birlikte, DistilBERT'i oluşturmak için Huggingface araştırmacıları, daha büyük, daha güçlü bir modeli (BERT) daha küçük bir modele (DistilBERT) sıkıştıran bir bilgi sıkıştırma yaklaşımı kullanmıştır. Bu teknik, daha küçük bir boyutta ve daha hızlı çıkarım süresinde daha büyük modele yakın bir performansın korunmasını sağlar.

DistilBERT, doğal dil işleme (NLP) alanında güçlü bir araç olduğunu kanıtlamıştır. Çeşitli araştırma projelerinde kullanılıyor ve bazı şirketler modellerini ve hizmetlerini iyileştirmek için zaten kullanıyor. Örneğin, Microsoft, soru cevaplama sistemlerinin performansını artırmak için DistilBERT'i kullanmıştır.

Kısacası, DistilBERT, BERT'ten daha küçük, daha hızlı, daha ucuz ve daha hafif bir modele ihtiyaç duyanlar için mükemmel bir seçenektir. Soru cevaplama sistemleri veya metin sınıflandırma gibi hızlı ve verimli bir modele ihtiyaç duyan uygulamalar için idealdir.

Topluluk için bir inceleme bırakın